एआई ह्यूमनॉइड नेचुरल वाकिंग में सक्षम

— फ़िगर 02 रोबोट अब एड़ी के वार, पैर की उंगलियों को ऊपर उठाने और सिंक्रोनाइज़्ड आर्म स्विंग के साथ इंसानों जैसी हरकतें करते हैं।

— यूएस रोबोटिक्स फ़र्म फ़िगर ने रीइन्फोर्समेंट लर्निंग का उपयोग करके एक प्राकृतिक ह्यूमनॉइड वॉकिंग मोशन विकसित करने में महत्वपूर्ण प्रगति की है।

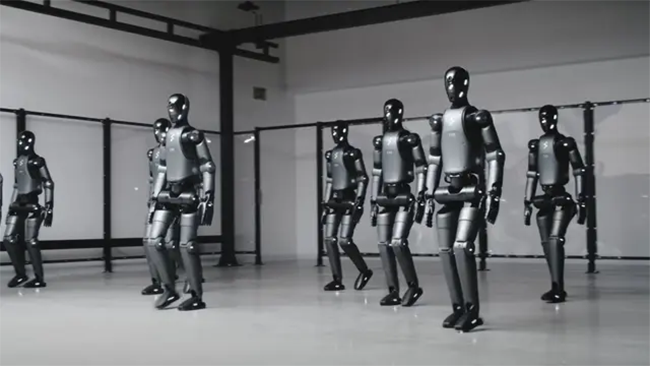

— फ़र्म द्वारा जारी किए गए एक नए वीडियो में इसके ह्यूमनॉइड रोबोट को सामान्य कठोर, यांत्रिक चाल की जगह अधिक तरल, प्राकृतिक गति के साथ चलते हुए दिखाया गया है।

फ़र्म के अनुसार, फ़िगर 02 एक भौतिकी सिम्युलेटर में रीइन्फोर्समेंट लर्निंग (RL) का उपयोग करता है, जो घंटों में वर्षों के डेटा का अनुकरण करता है। डोमेन रैंडमाइज़ेशन सिमुलेशन से वास्तविक दुनिया में चलने के लिए सहज, शून्य-शॉट स्थानांतरण को सक्षम बनाता है।

“हमने एंड-टू-एंड रीइन्फोर्समेंट लर्निंग का उपयोग करके पूरी तरह से सिमुलेशन में सीखा एक प्राकृतिक वॉकिंग कंट्रोलर प्रस्तुत किया है। यह फ़िगर रोबोट के बेड़े को मज़बूत, प्रोप्रियोसेप्टिव लोकोमोशन रणनीतियों को जल्दी से सीखने में सक्षम बनाता है और तेज़ इंजीनियरिंग पुनरावृत्ति चक्रों को सक्षम बनाता है,” फ़िगर ने एक बयान में कहा।

फरवरी में, फर्म ने हेलिक्स को पेश किया, जो एक विज़न-लैंग्वेज-एक्शन (VLA) मॉडल है, जो रोबोटिक्स की प्रमुख चुनौतियों से निपटने के लिए धारणा, भाषा समझ और नियंत्रण को जोड़ता है।

ह्यूमनॉइड स्वाभाविक रूप से चलते हैं

फिगर ने एक प्राकृतिक ह्यूमनॉइड वॉकिंग मोशन विकसित करने के लिए RL पर भरोसा किया है। RL, एक AI दृष्टिकोण जहां एक नियंत्रक एक रिवॉर्ड सिग्नल का उपयोग करके परीक्षण और त्रुटि के माध्यम से सीखता है, ने फिगर के ह्यूमनॉइड रोबोट, फिगर 02 को मानव जैसी चाल के साथ चलने में सक्षम बनाया।

कंपनी ने अपने RL कंट्रोलर को एक उच्च-निष्ठा, GPU-त्वरित भौतिकी सिमुलेशन में प्रशिक्षित किया, जो घंटों के भीतर वर्षों के डेटा का अनुकरण करता है। हजारों वर्चुअल ह्यूमनॉइड, जिनमें से प्रत्येक में अलग-अलग भौतिक पैरामीटर थे, समानांतर रूप से चलाए गए।

इस सिमुलेशन ने रोबोट को विभिन्न प्रकार के वास्तविक दुनिया के परिदृश्यों से अवगत कराया, जिसमें विविध इलाके, एक्ट्यूएटर डायनेमिक्स और स्लिप, ट्रिप और धक्का जैसी चुनौतियाँ शामिल हैं।

फिगर का दावा है कि इस व्यापक शिक्षण वातावरण के माध्यम से, रोबोट की गतिविधियों को प्रबंधित करने के लिए एक एकल तंत्रिका नेटवर्क नीति विकसित की गई थी।

फ़िगर के दृष्टिकोण का एक मुख्य लाभ यह है कि यह प्रशिक्षित नीति को बिना किसी अतिरिक्त ट्यूनिंग के सीधे सिमुलेशन से वास्तविक दुनिया के रोबोट में स्थानांतरित करने की क्षमता रखता है, जिसे "ज़ीरो-शॉट" स्थानांतरण के रूप में जाना जाता है। यह निर्बाध संक्रमण विभिन्न वातावरणों में मज़बूत, मानव-जैसा चलने का प्रदर्शन सुनिश्चित करता है।

फ़िगर के अनुसार, RL-संचालित प्रशिक्षण का लाभ उठाने से रोबोट की अनुकूलन क्षमता और विश्वसनीयता में वृद्धि करते हुए विकास चक्रों में उल्लेखनीय कमी आई है। AI रोबोट आगे बढ़े फ़िगर 02 रोबोट अब एड़ी के प्रहार, पैर की उंगलियों को ऊपर उठाना और सिंक्रोनाइज़्ड आर्म स्विंग सहित मानव जैसी हरकतें प्रदर्शित कर सकते हैं।

कंपनी के अनुसार, ये सुधार उनकी RL प्रशिक्षण प्रक्रिया का उपयोग करके प्राप्त किए गए थे, जो वेग ट्रैकिंग, ऊर्जा दक्षता और मज़बूती के लिए अनुकूलन करते हुए मानव चलने के प्रक्षेपवक्र की नकल करने के लिए रोबोट को पुरस्कृत करते हैं। वीडियो में, फ़िगर AI बिना किसी संशोधन के एक ही RL न्यूरल नेटवर्क पर काम करने वाले दस फ़िगर 02 रोबोट दिखाता है। यह एकरूपता इसकी तकनीक की मापनीयता को उजागर करती है, जो मैन्युअल समायोजन के बिना हज़ारों रोबोट तैनात करने की क्षमता प्रदान करती है। फर्म ने एक बयान में कहा, "हमने एंड-टू-एंड रीइन्फोर्समेंट लर्निंग का उपयोग करके पूरी तरह से सिमुलेशन में सीखा गया एक प्राकृतिक वॉकिंग कंट्रोलर प्रस्तुत किया है।

यह फिगर रोबोट के बेड़े को मजबूत, प्रोप्रियोसेप्टिव लोकोमोशन रणनीतियों को जल्दी से सीखने और तेजी से इंजीनियरिंग पुनरावृत्ति चक्रों को सक्षम करने में सक्षम बनाता है।" आगे देखते हुए, 2025 को फिगर एआई के लिए एक महत्वपूर्ण वर्ष के रूप में पेश किया जा रहा है क्योंकि यह उत्पादन शुरू करता है, रोबोट शिपमेंट बढ़ाता है, और होम रोबोटिक्स में प्रगति करता है। फर्म खुद को ह्यूमनॉइड रोबोटिक्स सेक्टर में टेस्ला के ऑप्टिमस, एजिलिटी रोबोटिक्स के डिजिट और यूबीटेक रोबोटिक्स और यूनिट्री रोबोटिक्स जैसी चीनी कंपनियों के साथ एक मजबूत प्रतियोगी के रूप में स्थापित कर रही है।

अपनी क्षमताओं का और विस्तार करते हुए, फिगर एआई ने हाल ही में हेलिक्स पेश किया, एक वीएलएम मॉडल जो रोबोट को प्राकृतिक भाषा निर्देशों का उपयोग करके जटिल कार्यों को निष्पादित करने में सक्षम बनाता है।

Brainy US humanoid robots walk like humans with smooth heel strikes

Humanoids walk naturally, AI robots advance

— Figure 02 robots now exhibit human-like movements with heel strikes, toe-offs, and synchronized arm swings.

— US robotics firm Figure has made significant progress in developing a natural humanoid walking motion using reinforcement learning.

— A new video released by the firm showcases its humanoid robots walking with a more fluid, natural motion, replacing the usual stiff, mechanical gait.

According to the firm, Figure 02 uses reinforcement learning (RL) in a physics simulator, simulating years of data in hours. Domain randomization enables seamless, zero-shot transfer from simulation to real-world walking.

“We have presented a natural walking controller learned purely in simulation using end-to-end reinforcement learning. This enables the fleet of Figure robots to quickly learn robust, proprioceptive locomotion strategies and enables rapid engineering iteration cycles,” said Figure in a statement.

In February, the firm introduced Helix, a Vision-Language-Action (VLA) model combining perception, language understanding, and control to tackle key robotics challenges.

Humanoids walk naturally

Figure has relied on RL to develop a natural humanoid walking motion. RL, an AI approach where a controller learns through trial and error using a reward signal, enabled Figure’s humanoid robot, Figure 02, to walk with a human-like gait.

The company trained its RL controller in a high-fidelity, GPU-accelerated physics simulation, simulating years of data within hours. Thousands of virtual humanoids, each with different physical parameters, were run in parallel.

This simulation exposed the robots to a variety of real-world scenarios, including diverse terrains, actuator dynamics, and challenges like slips, trips, and shoves.

Figure claims that through this extensive learning environment, a single neural network policy was developed to manage the robots’ movements.

A key advantage of Figure’s approach is its ability to transfer this trained policy directly from simulation to real-world robots without additional tuning, a process known as “zero-shot” transfer. This seamless transition ensures robust, human-like walking performance across various environments.

According to the Figure, leveraging RL-driven training has significantly reduced development cycles while enhancing the robot’s adaptability and reliability.

AI robots advance

Figure 02 robots can now demonstrate human-like movements, including heel strikes, toe-offs, and synchronized arm swings. According to the company, these improvements were achieved using their RL training process, rewarding robots for mimicking human walking trajectories while optimizing for velocity tracking, energy efficiency, and robustness.

In the video, Figure AI showcases ten Figure 02 robots operating on the same RL neural network without modifications. This uniformity highlights the scalability of its technology, offering the potential to deploy thousands of robots without manual adjustments.

“We have presented a natural walking controller learned purely in simulation using end-to-end reinforcement learning. This enables the fleet of Figure robots to quickly learn robust, proprioceptive locomotion strategies and enables rapid engineering iteration cycles,” said the firm in a statement.

Looking ahead, 2025 is projected as a pivotal year for Figure AI as it begins production, increases robot shipments, and advances in home robotics.

The firm is positioning itself as a strong competitor in the humanoid robotics sector, alongside Tesla’s Optimus, Agility Robotics’ Digit, and Chinese companies like UBTech Robotics and Unitree Robotics. Further expanding its capabilities, Figure AI recently introduced Helix, a VLM model that enables robots to execute complex tasks using natural language instructions.

https://interestingengineering.com/